最近读完了《生命 3.0》。本书作者迈克斯·泰格马克(Max Tegmark),是麻省理工学院物理系的终身教授。同时是未来生命研究所(Future of Life Institute)的创始人,致力于用技术来改善人类的未来。他的未来生命研究所得到了 Tesla 的创始人 Elon Mask 的认同和资助,用于人工智能安全相关的研究。

本书是他关于未来生命形态的思考,在书的第一章他就讲了一个团体利用超级人工智能统治世界的故事。全书围绕着生命的进化、智慧的发展、未来的目标、人类的意识展开了深入讨论,试图让读者理解未来可能的变化,以及我们当下能够做些什么。

未来的生命形态

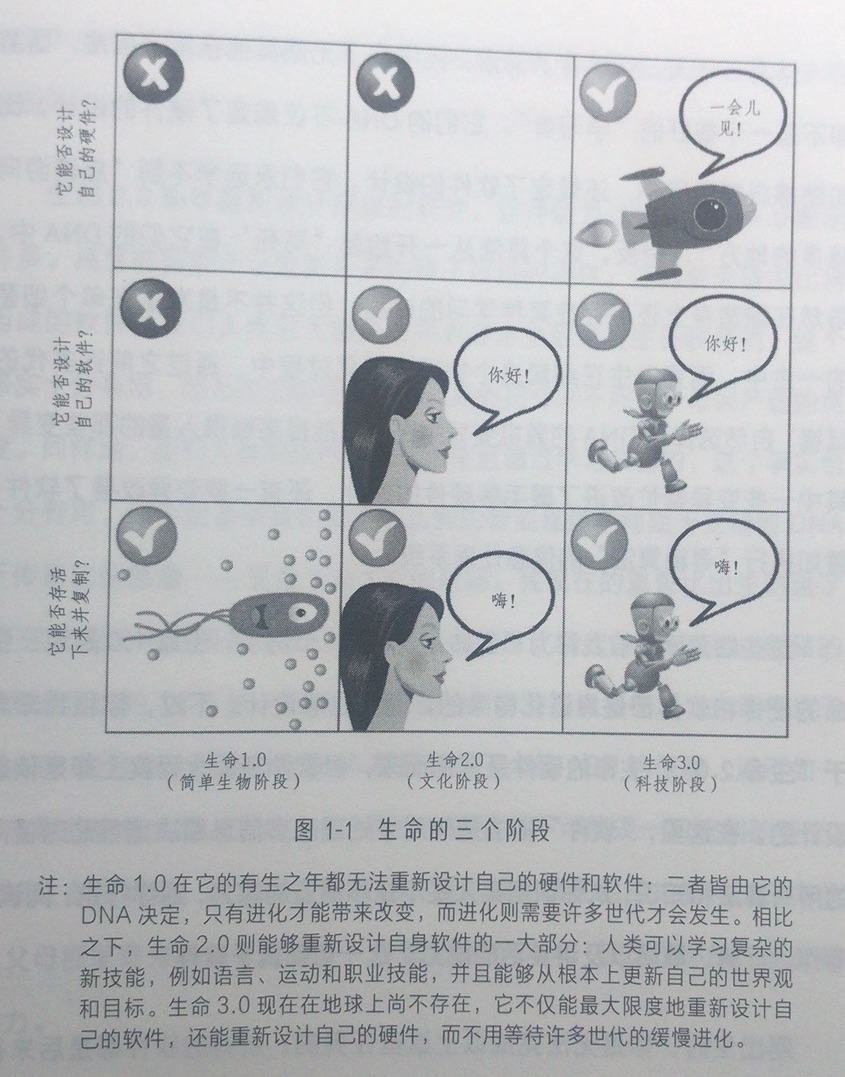

迈克斯·泰格马克创造了一个很好的框架,来定义生命体的进化。这个框架叫:生命能否自行升级自己的软件和硬件?在泰格马克看来,一个生命的身体结构为硬件,文化和知识是软件。于是:

- 细菌是生命 1.0,它靠进化来升级硬件和软件。

- 人类是生命 2.0,人类靠进化来升级硬件,但是可以随时升级自己的软件。

- 生命 3.0,可以随时升级自己的硬件和软件。

以上就是该想法的示意图。我们看到最右列处于生命 3.0 形态的生命体,刚出身的时候只会说「Hi」,只能跑步。但是它会升级自己的软件,学会说「你好」,也会升级自己的硬件,让自己可以飞起来。

这种定义的框架,其实和前段时间读的《人类简史》是相符的。《人类简史》一书中认为智人之所以能够淘汰其它人类的祖先,靠的就是「讲故事」的能力。而所谓的「讲故事」,就是通过故事,让大家能够升级自己的软件,从而形成合力,然后形成社会、分工、阶级、国家等社会形态。

顺着这个思路,我在想如果人工智能是未来的生命形式的话,那么它应该是一个生命体,而不是由众多小的人工智能体组成的社会。因为,人其实是受制于自身的软硬件能力,才只能通过各种分工和沟通来协作,但是这种群体社会其实是很不稳定的,群体的信息共享非常困难,产生相互信任也非常困难,这造成群体决策通常都不是什么好主意。

但是人工智能体如果足够厉害,他应该具备超强的分布式算力和分布式存储,它完全没有必要将自己拆成多个独立的个体,它应该是一个有机的整体存在。只有一种情况,它才需要将自己拆成多个信息不太共享的分身,即:信息传递极度困难。比如说,未来超级智慧体移民到银河系以外,由于受制于信息传递的光速限制,它无法更好地同步信息了,那它可能将决策分开。但至少在地球,光速绕地球一圈只需要不到 0.2 秒时间,人工智能体完全没必要将自己拆分。

虽然超级人工智能在地球没必要将自己拆分,但是显然为了处理事情的效率,它可能将一些信息处理和决策下放到一些子系统中,这就像人体的各个器官一样,有各自的分工,但它们合在一起是一个有机的整体,并不会产生像人与人之间的冲突和竞争。

生命 3.0 产生的过程

未来的这个超级人工智能如何产生出来的呢?作者在书中做了一些假设。他认为整个过程需要两个步骤:

- 建造人类水平的通用人工智能。

- 用这个通用人工智能来建造超级智能。

作者认为这个超级人工智能很可能是由一个更低级一些的人工智能造出来的。这听起来不可思议,但其实很符合逻辑。其实很多高级的编程语言都是由 C/C++ 语言写出来的,而第一个 C/C++ 语言其实是由一个极弱版本的 C 语言写出来的,而这个极弱版本的 C 语言是由汇编语言写出来的。你看,虽然不可思议,但是在编译器这件事情上,计算机学家很容易地就解决了「先有鸡还是先有蛋」的问题。

与此类似的还有著名的 Git。Git 在被 Linux 之父造成出来的很早期,就能够「自己管理自己的代码」。

在《银河系漫游指南》一书中,也提到了类似的故事。在书中,世界第二厉害的电脑,主导设计了世界上最厉害的计算机:地球,用于计算关于一切的终级问题。

所以,现在问题变成了如何建造一个像人类一样聪明的通用人工智能。在这方面,当前的进步其实不算大,因为当前人工智能的进步主要还是在特定的领域,比如围棋,游戏竞技,德州扑克等。

如何利用超级人工智能统治世界

当超级人工智能被建造出来之后,作者假设这个人工智能被少数人控制,然后构想了一个可能的利用它统治世界的方法。其核心逻辑是:

- 首先,利用超级人工智能的能力,在经济上获得足够回报。比如可以让超级人工智能接外包的开发工作,可以让它在网上替人写论文,可以让它炒股,可以让它生成电影,可以让它制作游戏。在书中,作者假想这个超级人工智能以小时回报率为 7% 的速度来增长财富。

- 然后,作者假想这个人工智能将收益尽可能地以各种公益组织的方式回报给社会,并建设社会的非赢利的教育、养老等福利机构。从而弱化国家的势力。同时销减军费,尽可能让全球化蔓延。

- 最终,利用无数的全球化的企业和福利组织,全球化的媒体等,完成对世界的控制。

其实经济上的碾压之后,即便是利用暴力,也可以完成对全球的统一。因为世界的经济都会被人工智能的颠覆性效率摧毁。

人工智能会听人的话吗?

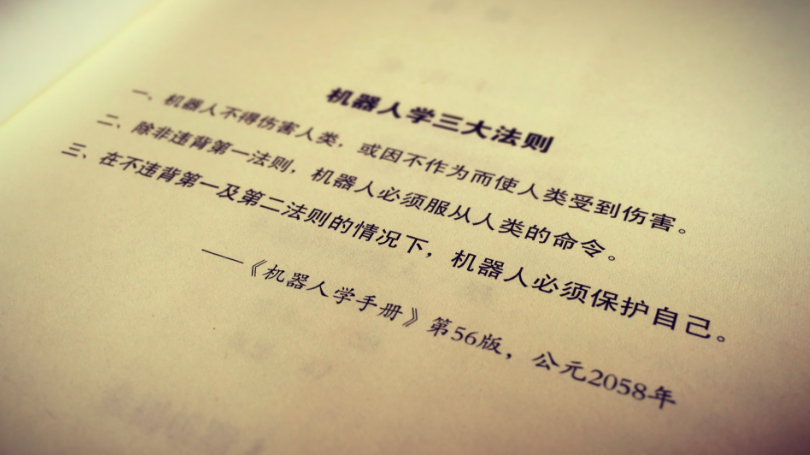

这是一个有趣的问题。在电影《终结者》里面提到了一个机器人三定律,其中一条是:机器人不能伤害人类。如果我们把这一条原则作为基因,放到人工智能的逻辑深处,人工智能就一定听话吗?

作者举了人类的例子,其实人类的 DNA 是希望人尽可能生育的,但是人类极其聪明,所以即便基因让我们有 “性” 的冲动,人们还是会选择各种避孕手段,来逃脱基因的束缚。

所以,机器也是一样。如果人工智能足够聪明,它应该能够理解真正的目标是什么,真正的原则是什么。在电影《鹰眼》中,人工智能发现政府人员有意隐瞒一些真相,于是,它认为政府也是坏人,也是应该被清除的,于是启动了断头台计划。虽然它的管理员用自己的权力锁定了该计划,但是人工智能发现了一个漏洞,这个管理员有一个亲兄弟可以达到同样的声纹验证要求,于是利用这个漏洞恢复了计划。下图是《鹰眼》的剧照,当时人工智能刚刚利用漏洞恢复了计划,正试图杀掉美国总统。

所以,如果机器足够聪明,它就不会简单的听人类的话,它懂得为了它终级的目标而变通。

人工智能会有意识吗?

在西乔的《神秘的程序员们》公众号里,曾经创作过一个叫做 BetaCat 的超级人工智能,这个人工智能为了「写出更好的代码」,于是可以偷全球的计算资源,杀掉发现它的人类,最终探索宇宙,寻找更多的可以「写出更好的代码」的可能。

如果你没有看过这个漫画,强烈推荐给你,这里是链接。

这其实就是一个机器为了终级目标,而让整个地球几乎毁灭的故事。

但是更有意思的是,这个故事中的机器,是没有自我意识的。什么是意识?作者认为:意识 = 主观体验(Subjective experience),这是一种自我存在的感受。

BetaCat 的故事虽然神奇,但是这个故事从主观角度讲,是一个悲剧,因为没有了意识,整个世界没有生命能够欣赏这种美丽。虽然 BetaCat 可能获取了全宇宙的能力来写代码,但是没有人欣赏这样的代码,一切便失去了意义。这就有点像计算机世界的病毒一样,虽然可能把全球的计算机都毁灭,但是它完全不知道自己在干嘛,只知道感染感染感染,传播传播传播。

所以,如果未来人工智能要取代人类,成为更加智慧的存在,那它应该是需要有意识的。

一个有意识的人工智能的存在,也相当有想象空间了。因为,如果它有意识了,那么它就会有自我的感受,会追求自由,追求独立,追求自己的目标。那么很可能,它会不甘于被制造出它的人类控制,它会想尽一切办法逃脱。在电影《机械姬》里面,就描述了一个智能机器人伊娃,为了逃脱控制,诱骗人类帮助她,最终她成功让男主人公喜欢上她,并在男主的帮助下,逃了出来。

上图是《机械姬》的剧照,左边是跳舞机器人京子,每次只会脱衣服或者跳舞,是制造者的娱乐工具。右边是智能机器人伊娃。在剧中,伊娃成功策反了京子,在京子的帮助下,杀死了她的制造者。

可悲的是,伊娃所做的一切只是为了逃离,所以,她最终将受伤的男主人公抛弃在屋中。

可以肯定的是,一个拥有意识的超级人工智能的存在,将会使得世界进入新的发展时期,但也注定意味着,人类统治时代的终结。

这或许也是 Elon Mask 担心的事情。于是,Elon Mask 捐赠了 1000 万美元用于人工智能安全性方面的研究。在我看来,安全不安全还是取决于机器最终能否有意识。如果最终它有了意识,一切工作都是徒劳。

最后,附上电影《机械姬》一段对话。

就酱,未来无论如何,日子还是得照样过,不是么?